总结

- CNN中的卷积层的filter个数可以增加网络的表达能力

- 但是过多的数量会让计算开销增加的太大

- 传统方法用maxout函数来达到增加表达能力又不增加太多计算开销的目的

- 当没有对于隐藏层分布先验信息的情况来说,用一个能拟合所有函数的结构要更适合一些(maxout只能拟合所有凸函数)

- 比较常见的能拟合所有函数的结构有两个

- radial basis network

- multilayer perceptron

- 本文选择了multilayer perceptron 有如下两个原因

- multilayer perceptron可以使用反向传播训练与CNN结合的比较好

- 可以扩展,自己当做一个深层网络

- 新的结构就叫做mlpconv,其实就是后面接了两层1X1卷积

- 此外还提出了一种新的结构全局平均池(Global Average Pooling)代替传统最后一层的FC层

- 先为每个分类结果项生成一个feature map(最后一层卷积的filter数量等于类别数量即可)

- 然后对每个feature map取平均得到一个向量

- 直接用改向量做softmax

- 这么做的好处有两个

- 让最终feature map的结果更加直观

- 这种结构没有参数,避免过拟合

- CIFAR-100实验结果

- top1 35.68%

Abstract

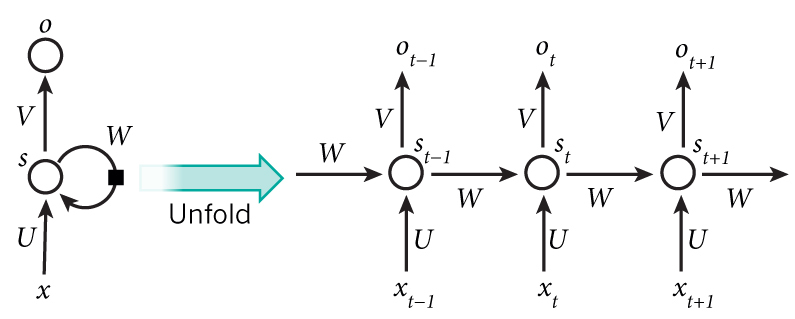

We propose a novel deep network structure called “Network In Network”(NIN) to enhance model discriminability.

We build micro neural networks with more complex structures to abstract the data within the receptive field.